Andromeda-Galaxie M31

Schwere Kost am 8. Kurstag, denn nun wurde das technische Vorstellungsvermögen der Kursteilnehmer auf eine harte Probe gestellt: Es ging ins Innere einer Digitalkamera. In ihr Allerheiligstes: Der Fotochip oder auch Fotosensor genannt. Denn sein Verhalten – insbesondere bei Langzeitbelichtungen – prägt das Verfahren, mit welchem moderne Astrofotos entstehen.

Prinzipiell gibt es zwei verschiedene Arten von Sensoren, wie sie in Digitalkameras verbaut werden: CCD- und CMOS-Chips. Doch wie funktionieren diese technischen Wunderwerke und worin unterscheiden sie sich? Was was bedeutet das für die astronomische Langzeitfotografie? Fragen über Fragen, die einer Klärung bedürfen…

CCD- und CMOS- Chips bestehen aus dotiertem Halbleitermaterial, welches bei Lichteinfall elektrische Ladungen freisetzt. Man spricht dabei auch von dem Inneren Fotoeffekt. Denn bei n-oder p- dotierten Halbleitern können überschüssige Elektronen bzw. deren Fehlstellen (Defekt-Elektronen) sehr leicht bewegt werden, da sie relativ schwach in dem meistens aus Silizium oder Metalloxid bestehenden Festkörper eingebunden sind. Diese Eigenschaft erreicht man bei n-dotieren Halbleitern mit 5-wertigen Stoffen (z.B. Posphor), bei p-dotierten Halbleitern mit 3-wertigen Elementen (etwa Aluminium). Dabei genügt bereits eine sehr geringe Zugabe dieser Zusatzstoffe.

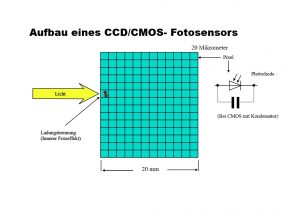

Die Abmessungen dieser Halbleiter-Sensoren betragen etwa 20 Millimeter. Auf diesen 20×20 mm2 großen Chips befinden sich dann 10-20 Millionen (!) einzelne Schaltkreise, welche aus diesem lichtempfindlichen Material aufgebaut sind. Wie man leicht nachrechnen kann, besitzen diese Schaltkreise, deren Hauptbestandteil eine eigenständige Photodiode darstellt, Abmessungen von weniger als 20 Mikrometer (20 tausendstel Millimeter). Eine andere Bezeichnung für diese Mikrometer großen Schaltkreise ist weitaus geläufiger: Das Pixel.

Bei CMOS-Sensoren (Complementary Metal Oxide Semiconductors) sind im Gegensatz zu CCD-Chips (Charge-Coupled-Device) mit ‚intelligenten‘ Pixeln ausgestattet. Jedes dieser Pixel ist imstande, den durch den Lichteinfall verursachten elektrischen Stromstoß (die elektrische Ladung) in einem parallel geschalteten Kondensator zu speichern. Beim Abrufen der Information durch die Recheneinheit wird jedes Pixel einzeln abgefragt und verschickt seine gesammelte Ladung über einen Analog-digital-(AD)-Wandler.

CCD-Chips hingegen verfügen über keine eigene Speicherungs-möglichkeit. Bei ihnen wird die vom Lichteinfall aufgeprägte Ladungsinformation zeilenweise vom Chip ausgelesen und dann ebenfalls über einen AD-Wandler der zentralen Recheneinheit zur Verfügung gestellt.

Vorteile und Nachteile

Der Grund, warum in den meisten Digitalkameras CMOS-Chips und keine CCD-Chips verbaut werden, liegt an den günstigeren Herstellungskosten und dem geringeren Stromverbrauch, der sie für den mobilen Einsatz prädestiniert. Der Nachteil der CMOS-Chips ist jedoch ihrem Aufbau geschuldet; denn durch die Einbeziehung weiterer elektrischer Komponenten (z.B. des Kondensators) in das Layout des Pixels geht etwas nutzbare fotoelektrische Fläche verloren. Und damit sind sie im Lichtverwertungsgrad etwas etwas schlechter als ihre CCD-Pedants. Außerdem verursacht ihr Aufbau ein erhöhtes Rauschen.

Unerwünschte Quereffekte

Doch beide Chiparten liefern kein exaktes Signal, welches 100%ig dem Lichteinfall auf den einzelnen Photodioden-Pixeln widerspiegelt. Zum einen ist das Auslesen der Informationen in beiden Varianten über den AD-Wandler mit Fehlern behaftet. Nicht jedes einzelne freigesetzte Elektron kann eindeutig jedem Pixel zugeordnet werden. In diesem Fall spricht man von Ausleserauschen. Weiterhin verursachen die Wärmeschwingungen des Halbleiter-Kristallgitters freigesetzte Ladungen, da diese ja durch das Dotierungsmaterial relativ einfach abgespaltet werden können. Die Anzahl der durch Wärmeschwingungen freigesetzten Ladungsträger steigt mit der Temperatur. Diese Art von Rauschen, die nichts mit dem einfallenden Licht zu tun hat, wird auch Dunkelrauschen genannt und steigt mit zunehmender Umgebungstemperatur – etwa alle 6° um das Doppelte. Nicht ohne Grund ist daher der Fotosensor in einigen hochwertigen Kameras in ein kühlendes Peltier-Element eingebaut (oder man besorgt sich selber eines).

Aber auch die Art des Verbaus des Sensors in der Kamera und die Geometrie der Kamera und des Objektivs tragen zur Verfälschung des Bildes bei. Der Grund dafür liegt in der ungleichmäßigen Ausleuchtung des Chips, die durch Abschattungen von Bauteilen aber auch von Staub innerhalb der Kamera verursacht wird.

Korrekturmöglichkeiten

Wie wir gesehen haben, gibt es prinzipiell 3 Störquellen, die das ursprüngliche Lichtsignal verfälschen: Das Ausleserauschen, das Dunkelrauschen und die ungleichmäßige Sensorausleuchtung.

Um von dem Foto diese Störsignale zu entfernen, ist schließlich ein Computer mit geeigneter Bildbearbeitungssoftware erforderlich. Am Schluss dieses Artikels findet der interessierte Leser einige Links zu frei verfügbarar, kostenloser Software.

Bias

Um das Ausleserauschen zu erfassen, deckt man die Kamera komplett ab und schießt mehrere Bilder mit der kleinsten Belichtungszeit, die die Kamera hergibt. Diese Bilder werden dann vom Bildbearbeitungsprogramm zu einem Master-Bias gemittelt.

Dunkelbild (Darks)

Auch der wärmeabhängige Dunkelstrom kann ermittelt werden. Dabei werden ebenfalls mehrere Bilder bei gleicher Belichtungszeit wie das Originalbild und vor allen Dingen bei gleicher Temperatur und ISO-Zahl aufgenommen und dann ebenfalls über ein Bildbearbeitungsprogramm zu einem Masterdark gemittelt. Man erhält über eine Fotosaison also eine ganze Menge an Masterdarks, sowohl für die ISO-Zahl als auch für eine bestimmte Temperatur.

Flats

Um die Abschattungseffekte der Kamera festzustellen, wird ein sogenanntes Flat erzeugt. Hierzu fotografiert die Kamera eine gleichmäßig ausgeleuchtete weiße Fläche. Es müssen mindestens 20 Einzelbilder geschossen werden (Belichtungszeit etwa 100ms oder etwas weniger). Es ist empfehlenswert, anschließend auch die zugehörigen Darks bei abgedunkeltem Objektiv (sog. Flat-Darks zu schießen), damit das Temperaturrauschen im Flat entfernt werden kann. Das Master Flat-Dark wird dann von jedem einzelnen der 20 Flats mit Hilfe eines Bildbearbeitungsprogramms abgezogen. Anschließend werden die entrauschten Flats zu einem Masterflat gemittelt. Es ist dabei darauf zu achten, dass das Flat zwar unabhängig von der Temperatur immer benutzt werden kann; wird jedoch die Geometrie der Kamera verändert (z.B. anderes Objektiv, anderer Filter usw.) muss für diese Konfiguration ein neues Flat erzeugt werden. Zu guter Letzt kann noch das Master-Bias (s.o.) vom Materflat abgezogen werden. Abschließend sollte das Masterflat in eine Schwarz-Weiß-Aufnahme umgewandelt werden.

Alles da!

Nun haben wir alles, was wir für die optimale Bildkorrektur benötigen:

– Unsere eigentlichen Aufnahmen von unserem Objekt, sog. Lightframes (zeitsparend ohne Rauschunterdrückung aufgenommen)

– Das von der ISO-Zahl und der Umgebungstemperatur abhängige Masterdark und

– das von der Kamerageometrie und Objektiv/Teleskop abhängige Masterflat.

Das Stacking

Nun zum eigentlichen Bearbeitungsprozess mit den Bildern unseres Objektes. Wir gehen davon aus, dass wir zwischen 5 und 20 Einzelbilder von unserem Objekt (z.B. die Andromedaglaxie) vorliegen haben.

Zunächst wird das Masterdark von jedem dieser Einzelframes abgezogen. Danach wird das Masterflat von jedem einzelnen dieser entrauschten Bilder dividiert. Dann werden die entrauschten und ‚geflatteten‘ Bilder zu einem Summenbild aufaddiert; in diesem Zuammenhang spricht man auch von ‚Stacken‘. Und fertig ist das fehlerbereinigte Astrofoto! Mathematisch kann das übrigens auf die Formel

Ergebnisbild = (Lightframe_1 – Masterdark)/(Masterflat – Bias) +

(Lightframe_2 – Masterdark)/(Masterflat – Bias) +

… +

(Lightframe_N – Masterdark)/(Masterflat – Bias)

ausgedrückt werden, wobei Lightframe_1 das erste Bild ist, Lightframe_2, das zweite, …usw bis zum N.-ten Lightframe_N; dem letzten. N bewegt sich dabei zwischen 5 und 20. Wichtig: Je mehr Bilder wir von unserem Objekt aufgenommen haben (größeres N) desto rauschfreier wird unser Ergebnis.

Doch welche Bildbearbeitungssoftware kann uns dabei am besten unterstützen? Hier gibt es verschiedene Softwarelösungen für den Astrofotografen, die z.T. kostenlos verfügbar sind: Empfehlenswert sind Fitswork oder der DeepSkyStacker. Die weitere Verarbeitung und Veredlung der Bilder kann mit Gimp vorgenommen werden.

Und nun viel Spaß beim Experimentieren. Und keine Sorge, wenn’s zu Anfang noch nicht so recht gelingen will: Es ist immer noch kein Astro-Meister vom Sternenhimmel gefallen!

Die Hausaufgabe

Die Hausaufgabe war klar: Mit der eigenen Kamera die erforderlichen Bilder für ein Flat zu schießen. Wer möchte, kann auch schon ein paar Dunkelbildserien bei unterschiedlicher Temperatur anfertigen (hier bitte auf die ISO-Zahl und Belichtungszeit achten, die auch für die Astrobilder verwendet wird).